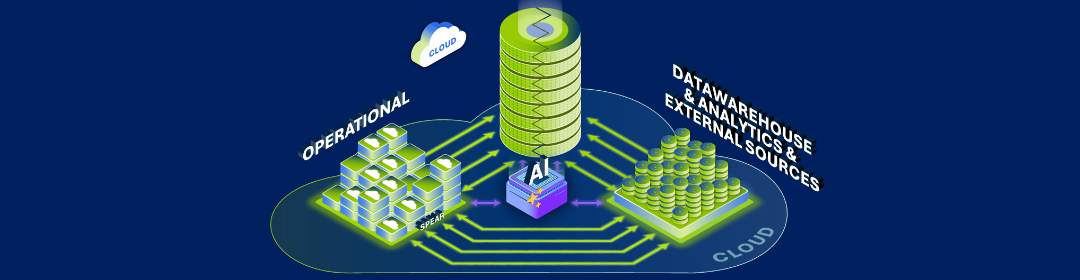

On le sait : le client est roi. Et notre clientèle a de plus en plus d’attentes liées au digital. Les entreprises, y compris la nôtre, doivent donc exploiter les données pour offrir des services digitaux personnalisés et rationaliser leurs opérations. Or, notre data platform on-premises était devenue un véritable goulet d'étranglement. Incapables de gérer efficacement les grandes quantités de données structurées et non structurées, nous avons choisi d’évoluer vers un environnement basé sur le cloud.

Patrick Sergysels

Head of Data Management

Chief Information Security Officer

Évolution des exigences des clients

L'évolution d'AG Insurance doit refléter celle des besoins de ses clients. Ils s'attendent à des services à la demande, personnalisés et sans points de friction. Nous nous sommes engagés à répondre à ces demandes.

Pour y arriver, nous devons mieux comprendre les besoins de nos clients. Comment ? En facilitant l’accès à l’énorme quantité de données structurées et non structurées dont nous disposons sur nos clients.

Une infrastructure à rénover

Une enquête interne et un gap assessment ont révélé que nous ne disposions pas des moyens nécessaires pour traiter les données requises, ce qui nous empêchait de développer des uses cases complexes. Notre dispositif était donc inefficace.

Notre data platform on-premisses avait été conçue pour stocker les données et pour mettre à jour ces données tous les mois. Nous avons donc fait évoluer notre plateforme pour qu'elle supporte des mises à jour quotidiennes. Mais elle n'était toujours pas adaptée à des analyses avancées en temps réel. Or, les clients ne peuvent plus se contenter d'informations datant d'un mois concernant leurs demandes d'indemnisation.

Notre plateforme avait également besoin de plus d'évolutivité et d'élasticité pour gérer la quantité et le type de données que nous voulions collecter pour fournir certains services. Elle ne prenait pas en charge les données non structurées telles que les vidéos, les images, les données météorologiques… Ce qui limitait donc grandement le périmètre de nos services futurs.

De plus, nous ne pouvions pas mettre en place des processus d'automatisation, ni exécuter des tâches simples que des plateformes plus modernes peuvent accomplir, comme générer des reportings de base sur les clients, dans les délais attendus.

Le fait que nous utilisions encore des sets de technologies de données vieux de dix ans montre à quel point nous avions besoin de revoir notre architecture et notre technologie pour les adapter à nos ambitions et à nos besoins. Le cloud était la meilleure option pour moderniser nos systèmes de base et en assurer l’évolutivité et l’élasticité.

Assistance fiable

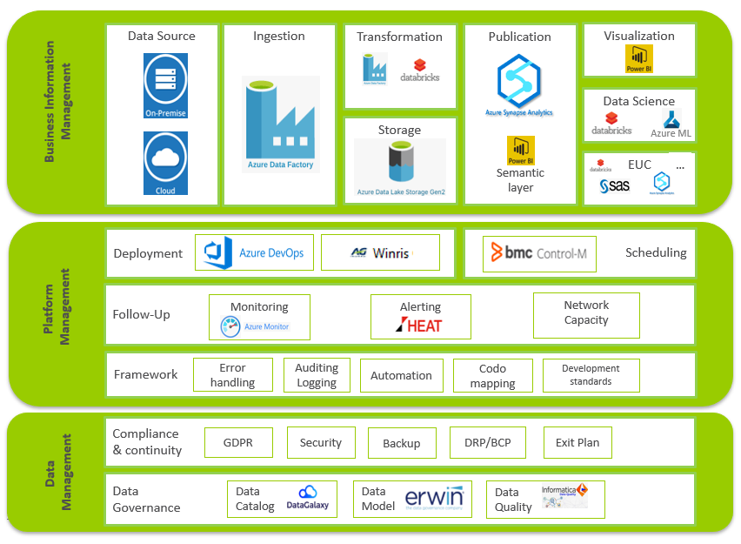

Compte tenu de l'ampleur de ce projet, nous avions besoin de l'aide de leaders technologiques. Nous avons choisi Microsoft comme système cible pour construire notre nouvelle data platform. Et ce, pour plusieurs raisons. AG Insurance s'appuie déjà sur les technologies de data stack de Microsoft et sur ses fonctionnalités de data warehouse Power BI, SSAS et SQL-Server.

Plus important encore, nous avons été séduits par la vision de Microsoft et sa volonté d'investir en permanence dans le développement de ses produits. Un pilote utilisant des fichiers fictifs a confirmé notre conviction que Microsoft était le bon choix. Il nous a également permis de réévaluer nos besoins technologiques, d'affiner les ressources nécessaires et de budgétiser le coût de cette opération.

Notre deuxième partenaire Hexaware s'occupait déjà du développement et de la maintenance de notre plateforme on-premises. Il a démontré son expertise et sa fiabilité au fil des ans.

Nos partenaires ont donc recréé la structure des données, réécrit le pipeline et transféré l'ensemble de l'historique des données de notre environnement sur site vers la nouvelle plateforme cloud.

Construire une nouvelle data platform

Notre équipe a créé le framework architectural en utilisant Microsoft Azure Databricks en plus de Microsoft Azure Data Lake Storage Gen2 pour gérer ses gros volumes de données et prendre en charge des analyses avancées.

Nous nous sommes appuyés sur Azure SQL DB comme référentiel central pour configurer le framework d'automatisation des données, ainsi que sur les pools SQL Synapse dédiés en tant que couche de publication pour ses systèmes en aval. Nous avons également déployé Azure Data Factory pour cartographier les flux de données et nous permettre de construire visuellement des ETL évolutifs. Simultanément, nous avons créé une end-user zone en self-service, à l'aide de Microsoft Power BI et d'outils Azure tels que Databricks. Le but était que les utilisateurs du business puissent se baser sur les données que nous préparons pour créer des reportings.

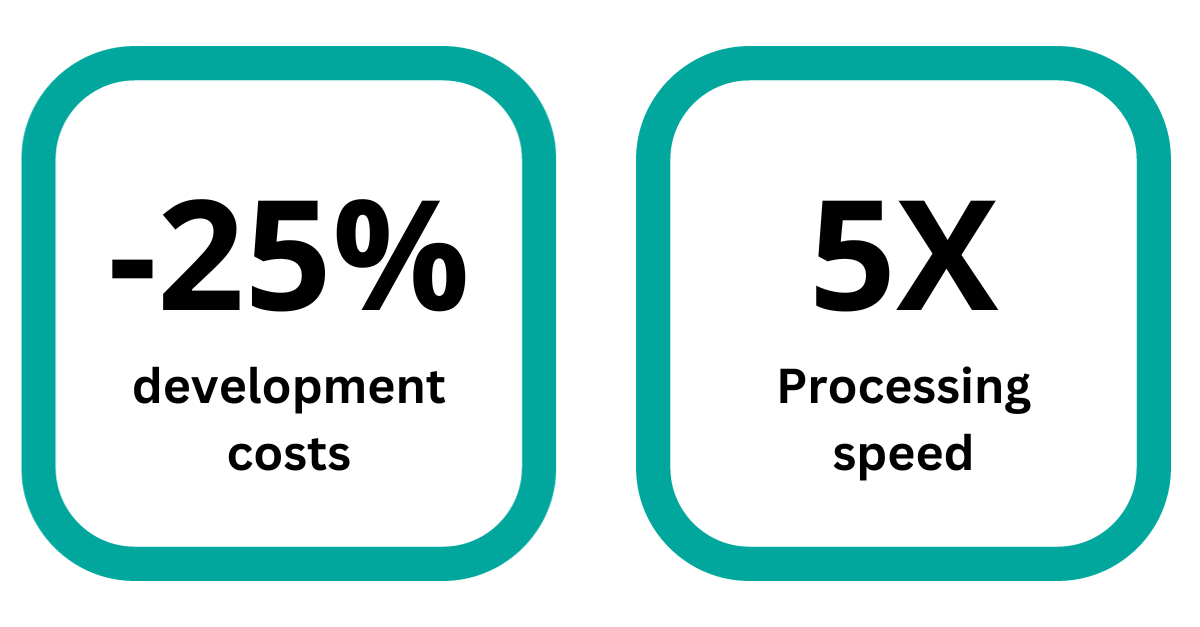

En plus de tous ces outils Microsoft, nous avons créé notre propre framework basé sur une série de services techniques utilisant PySpark. Ce framework permet un téléchargement rapide et plus rentable des données dans les couches inférieures.

L’épreuve du feu pour notre data platform

Lorsque nous avons construit notre architecture cible, nous avons testé notre data platform avec Hexaware comme co-pilote de confiance. Nous avons opté pour une approche progressive, en migrant une ou deux business lines à la fois, au lieu de procéder à un big bang.

Cela nous a permis d'évaluer le processus, de tester l'environnement au maximum et d’identifier d'éventuels points problématiques, ce qui fut le cas. Le pilote a révélé deux failles importantes que nous devions corriger avant de passer à la suite.

La première faille concernait notre stratégie de test. Nous avions l'intention de tester les performances, les pipelines et l'intégration de la nouvelle plateforme en copiant l'historique des données de notre plateforme de données on-premises vers notre nouvel environnement cloud et en laissant les deux plateformes de données fonctionner simultanément. Des résultats similaires dans les deux cas indiqueraient une migration réussie d'une plateforme à l'autre. Un écart révélerait en revanche un problème sur la nouvelle plateforme.

Le test a révélé quelques divergences. Mais alors que nous nous attendions à trouver les causes sur la nouvelle plateforme, nous avons rapidement réalisé que les différences auraient pu être causées par un éventail de facteurs plus large que prévu. Localiser les causes de ces divergences et les corriger s’est avéré beaucoup plus long et compliqué que prévu.

La deuxième faille concernait la qualité des données dans l'environnement on-premises. Notre nouvelle plateforme est équipée de paramètres stricts de qualité des données pour les futurs uploads. Nous n'avions pas prévu que ces paramètres signaleraient des ensembles de données erronées provenant de notre plateforme on-premises. Cela nous a permis d'éviter la migration de mauvaises données vers la nouvelle plateforme, mais a nécessité de nombreuses corrections.

Une fois ces obstacles surmontés, nous procédons actuellement à la migration, qui devrait être achevée d'ici mars 2024.

Profiter des avantages

Les fondations des innovations de demain

Le bénéfice majeur de ce projet est que nous pouvons désormais innover à l'infini pour améliorer nos processus business, nos services et l'expérience proposée à nos clients.

La nouvelle data platform nous permettra bientôt d'exploiter des analytics avancés pour faciliter le traitement des demandes d'indemnisation. Les clients pourraient télécharger des photos pour prouver les dommages qu'ils ont subis. Un algorithme comparerait ensuite les dommages visibles sur ces photos avec un vaste volume de données. Ce qui nous permettrait d’évaluer le coût des dommages et d’effectuer un paiement immédiat.