Patrick Sergysels

Head of Data Management

Chief Information Security Officer

Veranderende klantenbehoeften

Verouderde infrastructuur

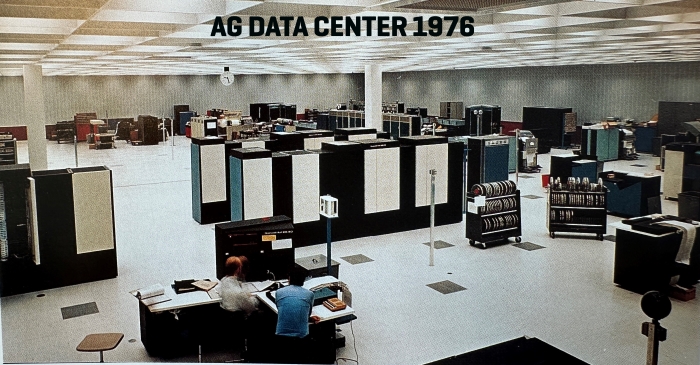

Doorheen de jaren hebben we ons platform opgeschaald om dagelijkse updates te ondersteunen, maar het bleef inadequaat voor geavanceerde realtime analyses. We hadden ook nood aan meer schaalbaarheid en elasticiteit om verschillende soorten en grote hoeveelheden data op te slaan. Ons eerder dataplatform ondersteunde geen ongestructureerde data, zoals video's, afbeeldingen en weergegevens, wat ons ernstig beperkte bij de ontwikkeling van nieuwe, innoverende producten.

Bovendien waren we niet in staat om automatiseringsprocessen te implementeren of zelfs relatief eenvoudige taken uit te voeren die modernere dataplatforms wel aankunnen, zoals het tijdig genereren van basisrapporten.

Het feit dat we nog altijd gebruikmaakten van decennia oude technologieën voor datasets illustreert hoe dringend we onze architectuur en technologie moesten vernieuwen. We wisten dat we met cloudtechnologie onze kernsystemen zouden moderniseren en onze schaalbaarheid en elasticiteit zouden verhogen.

Hulp van techgiganten

Gezien de omvang van dit project hadden we externe expertise en tools nodig. We kozen om verschillende redenen voor Microsoft als ons doelsysteem voor de bouw van ons nieuwe dataplatform. AG Insurance maakt immers al gebruik van diverse technologieën binnen de Microsoft-datastack en beschikt over on-premises datawarehouse-functionaliteiten zoals Power BI, SSAS en SQL Server.

Maar we waren vooral geïntrigeerd door de visie en toewijding van Microsoft om voortdurend te investeren in de ontwikkeling van hun producten. Een kleine pilot met dummybestanden bevestigde onze overtuiging dat Microsoft de juiste keuze was en liet ons toe onze technologische behoeften opnieuw te evalueren, onze resourcevereisten te verfijnen en de mogelijke kosten van deze operatie beter te begroten.

Onze tweede partner is Hexaware. Zij staan ons al jaren bij voor de ontwikkeling en het onderhoud van ons on-premises dataplatform en stonden de voorbije jaren al garant voor expertise en betrouwbaarheid. Onze partners hebben de datastructuur opnieuw gecreëerd, de pipeline herschreven en de hele datageschiedenis van onze on-premises dataomgeving overgezet naar het nieuwe cloudplatform.

Dataplatform in opbouw

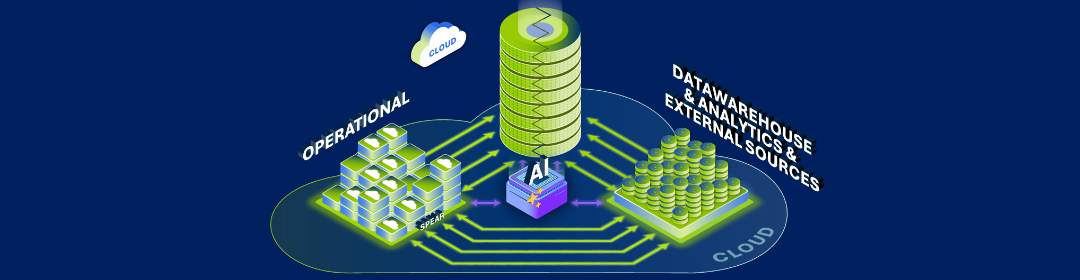

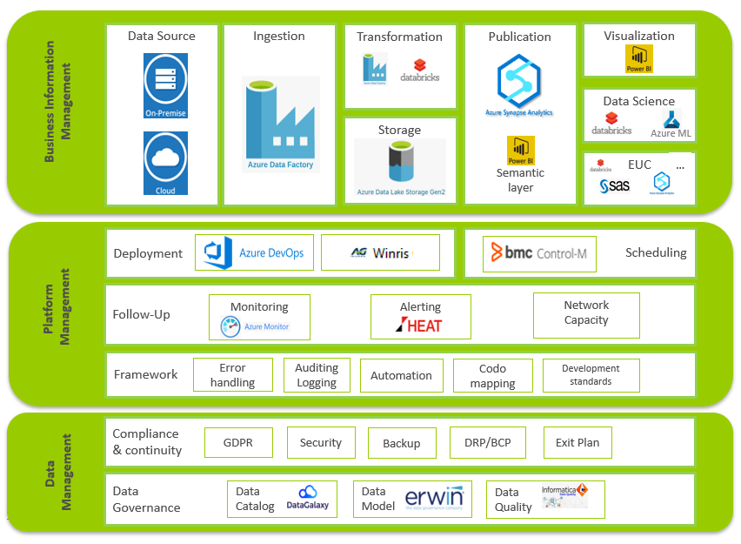

Ons team implementeerde het architectuurframework met Microsoft Azure Databricks, gecombineerd met Microsoft Azure Data Lake Storage Gen2, om enorme hoeveelheden data te beheren en geavanceerde analyses te vergemakkelijken.

Daarnaast vertrouwden we op Azure SQL DB als centrale opslagplaats voor het configureren van het data automation framework, en Synapse Dedicated SQL Pools als publicatielaag voor de downstreamsystemen. We hebben ook Azure Data Factory ingezet om dataflows in kaart te brengen en om schaalbare ETL's visueel te kunnen bouwen. Tegelijkertijd hebben we met behulp van Microsoft Power BI en Azure tools zoals Databricks een self-service end-userzone gecreëerd, waar business users gebruik kunnen maken van de data die we klaarmaken voor rapportage.

Naast al deze Microsoft tools, creëerden we ons eigen framework bestaande uit een reeks technische diensten met behulp van PySpark. Dit framework maakt het mogelijk om snel en kosteneffectiefdata te uploaden in de lagere lagen.

Moeizame eerste testritten

Eens we onze doelarchitectuur gebouwd hadden, hebben we een eerste business line gemigreerd. We kozen voor een gefaseerde aanpak waarbij we 1 à 2 business lines of departementen migreerden, in plaats van een Big Bang. Hierdoor konden we het proces stap-per-stap beoordelen, de omgeving volledig testen en pijnpunten blootleggen. Wat ook gebeurde. We botsten op twee grote mankementen.

De eerste tekortkoming was onze teststrategie. Aanvankelijk wilden we de prestaties, pipelines en integratie van het nieuwe platform testen door de datageschiedenis van ons on-premises dataplatform naar onze nieuwe cloudomgeving te kopiëren en beide dataplatformen tegelijkertijd te laten draaien. Vergelijkbare resultaten van beide runs zouden wijzen op een succesvolle migratie van het ene platform naar het andere. Bij een afwijkend resultaat zouden we het probleem op het nieuwe platform kunnen opsporen en oplossen.

De test bracht inderdaad enkele verschillen aan het licht. Maar waar we de oorzaken op het nieuwe platform verwachtten te vinden, bleek al snel dat de verschillen door heel wat meer factoren veroorzaakt konden worden. Het opsporen en oplossen van de oorzaken kostte ons dus veel meer tijd en energie.

De tweede tekortkoming was de ondermaatse datakwaliteit in onze on-premisesomgeving. Ons nieuwe dataplatform heeft stringente datakwaliteitsinstellingen voor toekomstige uploads. We hadden echter niet verwacht dat deze instellingen foutieve datasets van ons on-premises dataplatform zouden blootleggen. Hierdoor konden we onze datakwaliteit verhogen, maar liepen we uiteraard vertraging op.

Nadat we deze hindernissen overwonnen, zetten we de migraties verder. Tegen maart 2024 zal heel ons analytische hebben en houden op het nieuwe platform draaien.

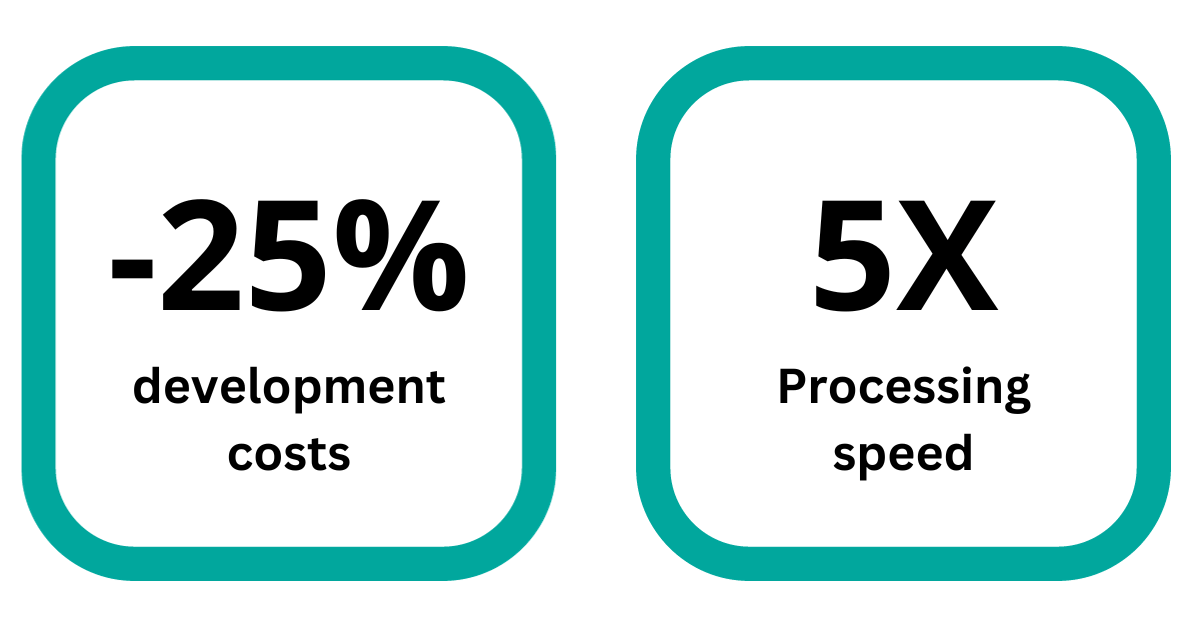

Instant rendement en langetermijnvoordelen

Bouwstenen voor toekomstige innovatie

Of wat dacht je van het in realtime personaliseren van menselijke interactie? In de toekomst zouden we de emotionele basistoestand van de klant kunnen bepalen op basis van eerdere interacties met onze diensten. Als een klant tijdens een stressvol moment contact met ons opneemt, zouden we op basis van toon of stemvolume kunnen detecteren of de klant afwijkt van die basistoestand. Dankzij deze inzichten zouden onze collega's hun communicatiestijl dan kunnen aanpassen.

Conclusie

Door de kracht van data en cloudtechnologie te omarmen, hebben we de basis gelegd om deze innovaties te verkennen. Daar zijn we nu volop mee bezig. We houden je op de hoogte van onze ontwikkelingen.

We wisten dat we het potentieel van dit nieuwe dataplatform echter alleen volledig zouden kunnen benutten door het te koppelen aan een operationele infrastructuur die even futureproof is. Mede daarom hebben we een unieke replatforming uitgevoerd. Ontdek meer over dit historisch project of lees een van de andere interessante artikels.